Spark简介

Spark最初由美国加州大学伯克利分校(UC Berkeley)的AMP实验室于2009年开发,是基于内存计算的大数据并行计算框架,可用于构建大型的、低延迟的数据分析应用程序

2013年Spark加入Apache孵化器项目后发展迅猛,如今已成为Apache软件基金会最重要的三大分布式计算系统开源项目之一(Hadoop、Spark、Storm)

Spark在2014年打破了Hadoop保持的基准排序纪录

Spark具有如下几个主要特点:

- 运行速度快:使用DAG执行引擎以支持循环数据流与内存计算

- 容易使用:支持使用Scala、Java、Python和R语言进行编程,可以通过Spark Shell进行交互式编程

- 通用性:Spark提供了完整而强大的技术栈,包括SQL查询、流式计算、机器学习和图算法组件

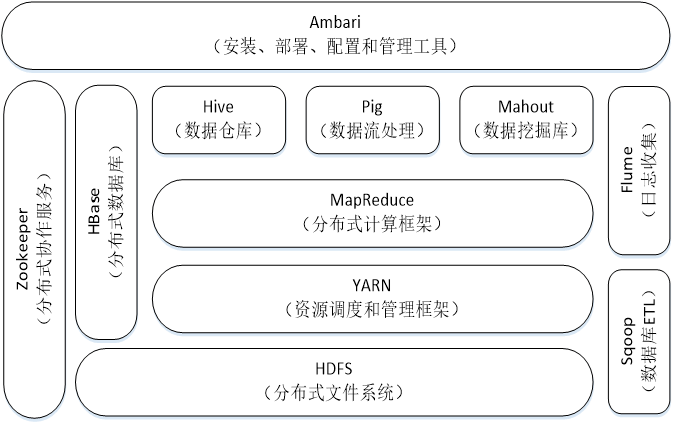

- 运行模式多样:可运行于独立的集群模式中,可运行于Hadoop中,也可运行于Amazon EC2等云环境中,并且可以访问HDFS、Cassandra、HBase、Hive等多种数据源

Spark与Hadoop的比较

Hadoop存在如下一些缺点:

- 表达能力有限

- 磁盘IO开销大

- 延迟高

- 任务之间的衔接涉及IO开销

- 在前一个任务执行完成之前,其他任务就无法开始,难以胜任复杂、多阶段的计算任务

Spark在借鉴Hadoop MapReduce优点的同时,很好地解决了MapReduce所面临的问题

相比于Hadoop MapReduce,Spark主要具有如下优点:

- Spark的计算模式也属于MapReduce,但不局限于Map和Reduce操作,还提供了多种数据集操作类型,编程模型比Hadoop MapReduce更灵活

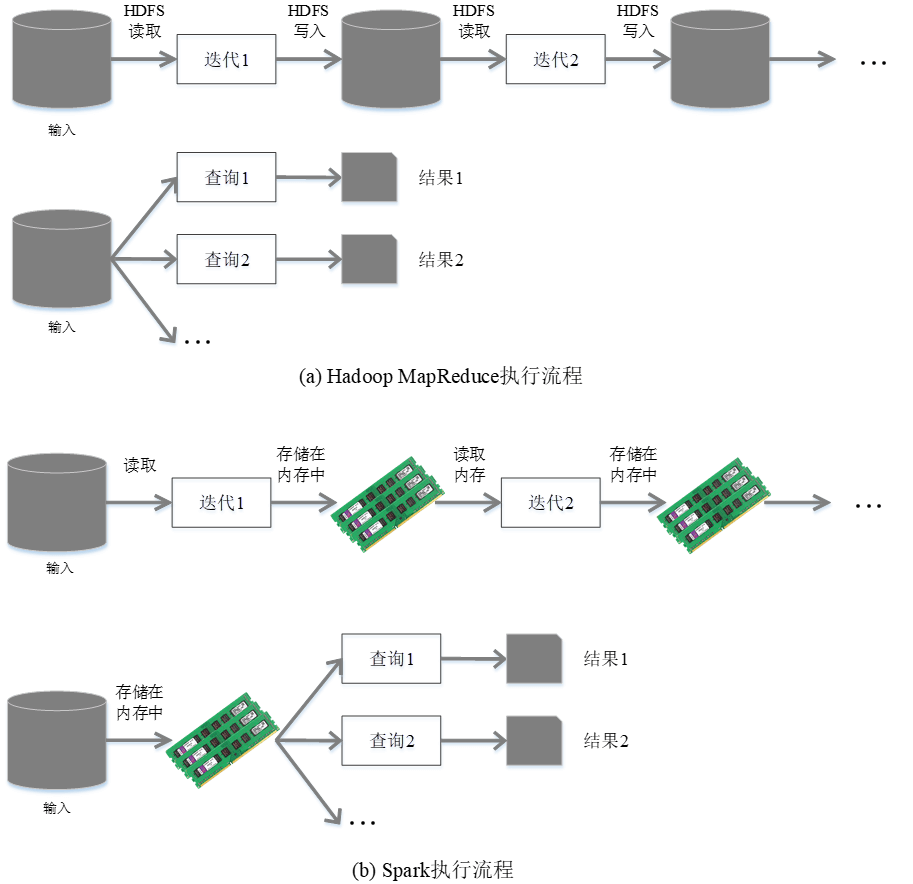

- Spark提供了内存计算,可将中间结果放到内存中,对于迭代运算效率更高

- Spark基于DAG的任务调度执行机制,要优于Hadoop MapReduce的迭代执行机制

使用Hadoop进行迭代计算非常耗资源

Spark将数据载入内存后,之后的迭代计算都可以直接使用内存中的中间结果作运算,避免了从磁盘中频繁读取数据

Spark生态系统

在实际应用中,大数据处理主要包括以下三个类型:

- 复杂的批量数据处理:通常时间跨度在数十分钟到数小时之间

- 基于历史数据的交互式查询:通常时间跨度在数十秒到数分钟之间

- 基于实时数据流的数据处理:通常时间跨度在数百毫秒到数秒之间

当同时存在以上三种场景时,就需要同时部署三种不同的软件,比如: MapReduce / Impala / Storm

这样做难免会带来一些问题:

-

不同场景之间输入输出数据无法做到无缝共享,通常需要进行数据格式的转换

-

不同的软件需要不同的开发和维护团队,带来了较高的使用成本

-

比较难以对同一个集群中的各个系统进行统一的资源协调和分配

-

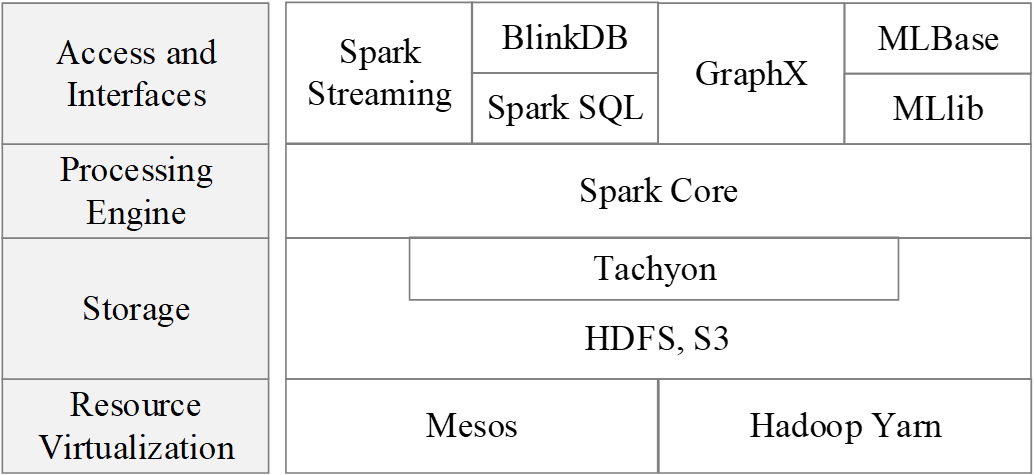

Spark的设计遵循“一个软件栈满足不同应用场景”的理念,逐渐形成了一套完整的生态系统

-

既能够提供内存计算框架,也可以支持SQL即席查询、实时流式计算、机器学习和图计算等

-

Spark可以部署在资源管理器YARN之上,提供一站式的大数据解决方案

-

因此,Spark所提供的生态系统足以应对上述三种场景,即同时支持批处理、交互式查询和流数据处理

Spark生态系统已经成为伯克利数据分析软件栈BDAS(Berkeley Data Analytics Stack)的重要组成部分

Spark的生态系统主要包含了Spark Core、Spark SQL、Spark Streaming( Structured Streaming )、MLLib和GraphX 等组件

| 应用场景 | 时间跨度 | 其他框架 | Spark生态系统中的组件 |

|---|---|---|---|

| 复杂的批量数据处理 | 小时级 | MapReduce、Hive | Spark |

| 基于历史数据的交互式查询 | 分钟级、秒级 | Impala、Dremel、Drill | Spark SQL |

| 基于实时数据流的数据处理 | 毫秒、秒级 | Storm、S4 | Spark Streaming Structured Streaming |

| 基于历史数据的数据挖掘 | - | Mahout | MLlib |

| 图结构数据的处理 | - | Pregel、Hama | GraphX |